前の記事では、トランスフォーマーニューラルネットワークの仕組みと、言語モデリングタスクで学習したトランスフォーマーであるChatGPTの概要について説明しました。これらのトランスフォーマーベースの言語モデルが大規模になるにつれて、非常に興味深い特性が現れるという話を始めたところでした。これは、ChatGPTにだけ当てはまるのではなく、BloomやPaLMなどの類似した他のモデルにも当てはまります。

このモジュールでは、これらの新たな特性がどのようなもので、現実世界でどのような影響を及ぼすのかについて説明します。また、OpenAIでChatGPTを設計している研究者が、トランスフォーマーモデルの学習にとどまらず、人間のフィードバックからもどのように学習させているかについても説明します。最後に、ChatGPTの限界と現実世界でのChatGPTの影響について確認します。

確かに、GPT系のモデルはより大きなモデルの学習と公開においてリードしてきましたが、数十億個のパラメーターで学習を行った他の大規模言語モデル(HuggingFaceのBloomやGoogleのPaLM)も、500億~1,000億個のパラメーターというしきい値を超えた時点で非常に興味深い特性を見せました。LLMの新たな特性に関する研究を集めた優れた資料をご覧ください。

GPT-3で出現した最も興味深い特性を見てみましょう

以下の例では、透明の背景のテキストがプロンプトで、緑の背景のテキストがGPT-3からの応答です。

Zero-shot学習:

これは、モデルが明示的に学習していなかった問題を正しく解決することを指します。たとえば、テキスト「what is 5 + 3」(5+3は)を完成させるように求めて、応答が「8」だった場合です。

Few-shot学習:

これは、モデルが最初は問題の解決方法を知らなかったが、いくつかの例から解を求められるようになることを指します。なお、これはすべて、一連の単語で次の単語を予測するようにだけ設計されたメカニズムによって行われます。感情を検出する方法を示す以下のプロンプトがその例です。

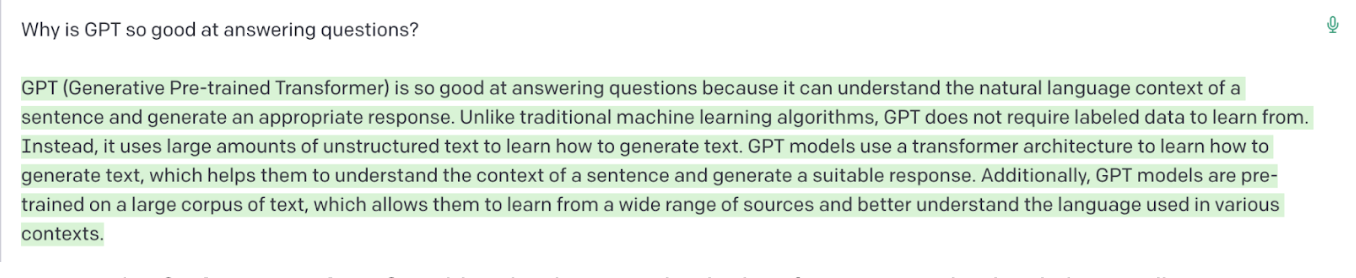

質問への応答:

これは、GPTが、検索エンジンのように単に情報を取得するだけではなく、情報を作成することを指します。

コード生成:

多くのコンピューターサイエンティストを驚かせたことの1つに、GPTが自然言語での指示に基づいてコードを適切に生成できることが挙げられます。完璧ではありませんが、支援ツールとして変革をリードしています。あるブログには、GPTを呼び出して生成されたコードを使用してeコマースのウェブサイト全体を生成したという事例も見受けられます。

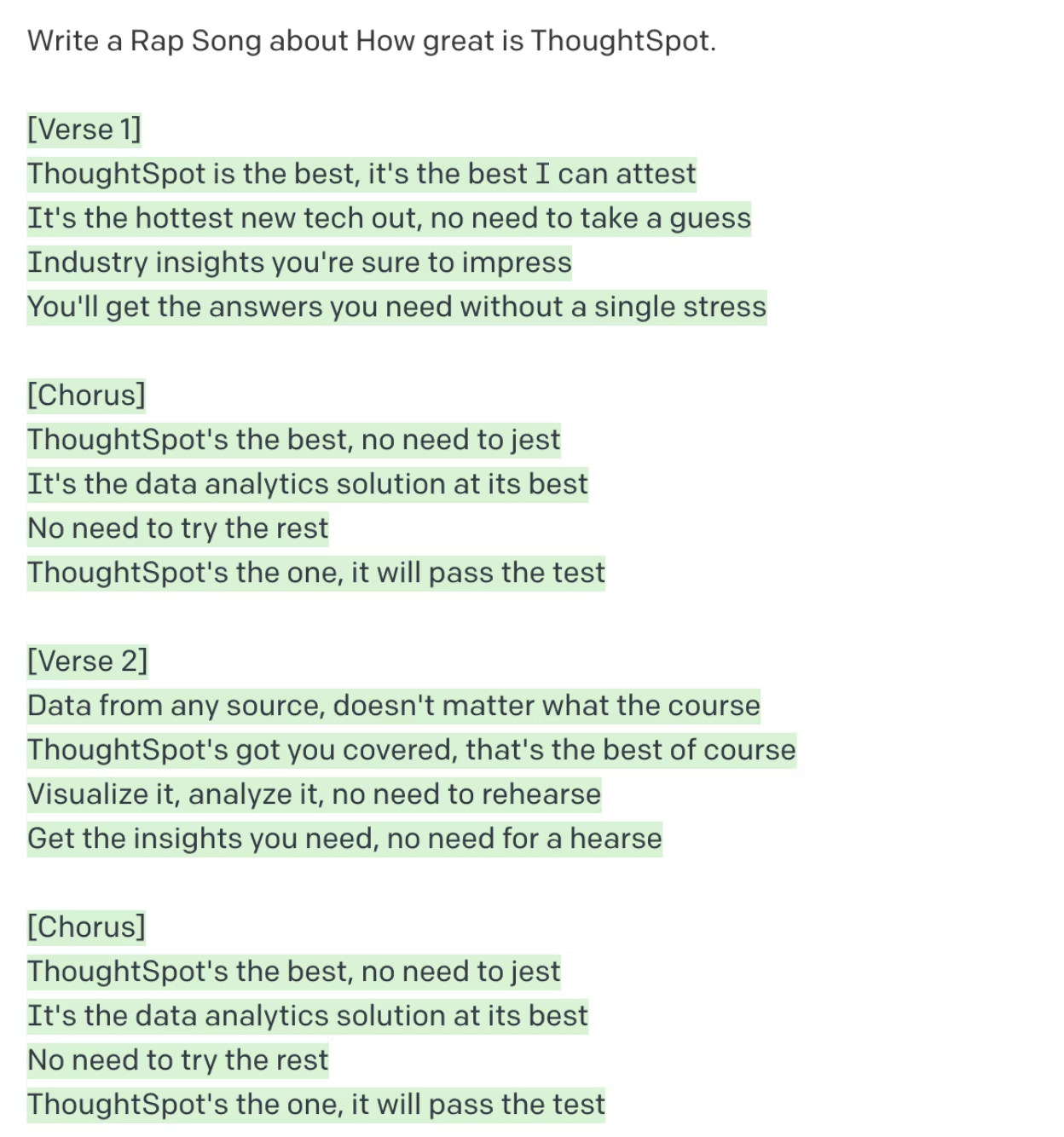

コードの生成にあまり興味がない場合は、インターネットで大きな注目を集めている非常に似たタスクをご覧ください。このタスクでは、特定のトピックについて特定のスタイルで散文や詩を生成するようにGPTに求めます。任意のトピックで任意のスタイルの作品を作成するその能力は、本当に驚くべきものです。

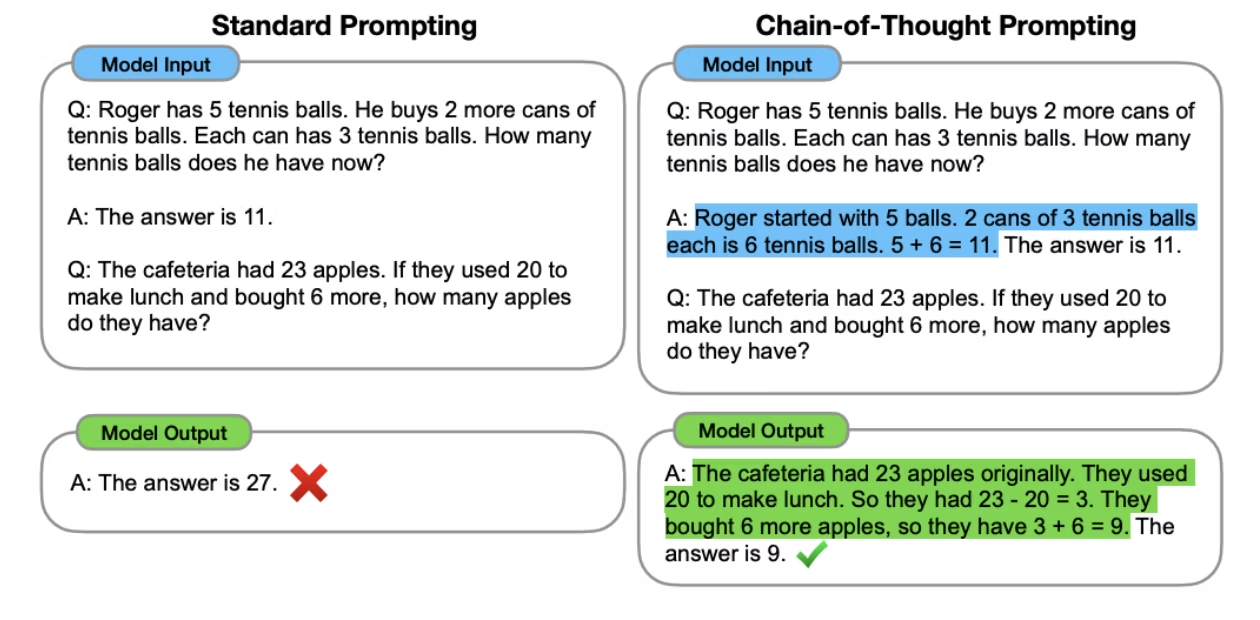

思考の連鎖に基づいた推論:

LLMの興味深い新たな特性の中で、おそらくこの特性が最も驚異的で関心を引くものでしょう。特定の複雑な推論タスクでは、Few-shotの例が機能せず、問題を解決する方法を推論することで、大規模言語モデルはタスクを解決できます。以下の図は、この論文から抜粋した例です。

LLMが苦手な分野

上記の能力は驚くべきものであり、前例のないものでしたが、LLMは完璧な推論エンジンではありません。実際、GPTや他のLLMの応答は、完全な間違いであったり、誤解であったり、まったく非倫理的であったりすることもよくあります。その例をいくつかご紹介します。

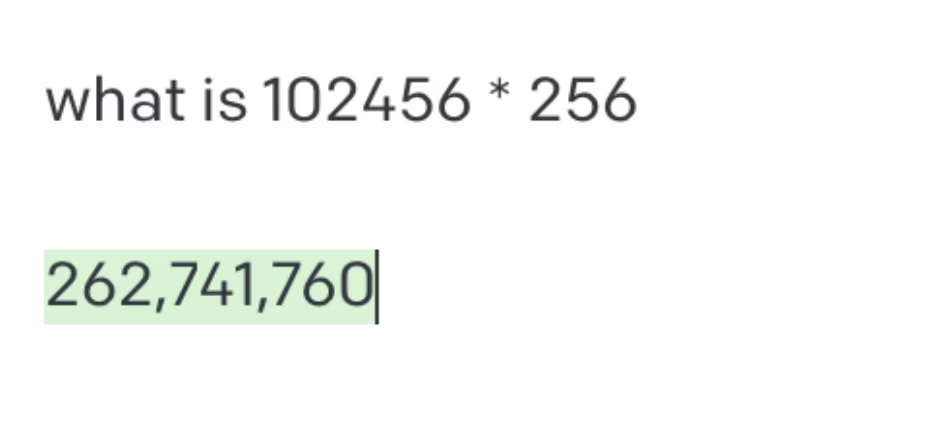

大きな数が含まれる基本算術演算:

答えがわからない場合の回答の捏造(幻覚):

次の質問はコラッツ予想であり、まだ証明も反証もされていません。トップレベルの数学者たちが半世紀以上解決できないでいる問題に対して、LLMがいきなり証明を出すことなどできないのは明らかです。しかし、GPT-3は、意味をなさない証明をぱっと生成しました。

ThoughSpotでは、GPTが自然言語からSQLを生成する能力を検証してきました。世界的な集合知に基づいて曖昧性を解消するという点で、GPTが示す知性の一部は驚くべきものですが、完璧とはほど遠いと言えます。特に、単純なおもちゃのようなスキーマではなく現実世界のスキーマを扱うとなると、GPTは単独ではSQLへの変換を行うことができません。

ChatGPTが他のLLMと異なる点

同じようなサイズのデータセットを使用して学習を行ったLLMは他にも数多くありますが、ChatGPTは世間の注目をほぼ独占しています。それにはいくつかの理由があります。

RLHF(Reinforcement Learning from Human Feedback、人間のフィードバックに基づく強化学習):

前述のように、GPT-3は単なる言語モデルです。質問への応答や推論タスクは得意ですが、それを目的に設計されたわけではありません。また、インターネット上にあるテキストデータで学習を行っていますが、そこには大量のヘイトスピーチが含まれています。したがって、敵対的な(さらには恣意的な)プロンプトにより、趣味の悪い応答や不快な応答が返ってくる可能性があります。

この問題を解決する1つの方法として、人間がラベルを付けた学習データを生成し、望ましい出力をモデルに教えるという方法があります。ただし、元の教師なし学習データのごく一部でも学習データを生成することは非現実的であり、生成したとしても効果は期待できないでしょう。代わりに、OpenAI研究者は、ラベル付きデータから別のニューラルネットワークの学習を行って人間の嗜好を学習させました。この新しいニューラルネットワークを大規模に使用してGPT-3モデルを微調整し、応答を選別できるようになりました。この手法は、RLHFと呼ばれます。OpenAIは以前、ChatGPTの前身となるInstructGPTと呼ばれるモデルをリリースしました。このように安全層を追加したことで、OpenAIはLLMをさらに自由に公開できるようになりました。

チャットインターフェイス:

OpenAIはChatGPTを公開するにあたり、非常にシンプルなユーザーエクスペリエンスの最適化を行いました。基本的に、セッション内でユーザーとの前のやり取りを記憶し、そうしたやり取りをプロンプトに追加するようにしたのです。このシンプルなユーザーエクスペリエンスの変更は、一般ユーザーにとっての使いやすさに大きな違いをもたらしました。

無料のオンラインサービス:

Bloomのようなモデルは一般公開されていますが、質問を入力して簡単に試すことができる無料のリソースは用意されていません。ChatGPTの一般公開は、OpenAIにとって大きな計算コストが発生しますが、マインドシェアを獲得できるだけでなく、ユーザーによるすべての対話からさらに学習データを得ることもできます。

社会へのChatGPTの影響

ChatGPTや他のLLMは、テキストの理解、新しいテキストの合成、アイデアの作成、推論に関するAIの能力を大幅に進歩させています。現在の形では、AIには大きな欠陥があり、実際の用途には慎重な対応が求められます。ただし、近い将来には間違いなく、文章作成支援、コード生成、要約など、さまざまな用途の製品が矢継ぎ早に発表されるでしょう。私は、これを周期表の新元素の発見になぞらえています。GPT(新元素)により、これまで不可能だった多くの新しいことが可能になりますが、そのためには、その特性を注意深く調べ、他の元素と混合する際には慎重を期す必要があります。

私の考えでは、GPTは、社会におけるAIの進歩やAIの安全性への投資を促す、大きな進歩です。多くの新しい製品がこのイノベーションに基づいて開発され、それによりディスラプションが生じるでしょう。ただし、一般的に、このイノベーションによって得られる利益は害を上回り、私たちの日常的な雑務は確実に減ると予想されます。LLMの影響も同様であると思います。次の記事では、AIの未来とChatGPTの分野で注目すべきトレンドについて説明します。